梦晨 一水 发自 凹非寺香港三级片

量子位 | 公众号 QbitAI继分不清9.11和9.9哪个大以后,大模子又“集体失智”了!

数分歧单词“Strawberry”中有几个“r”,再次引起一派看守。

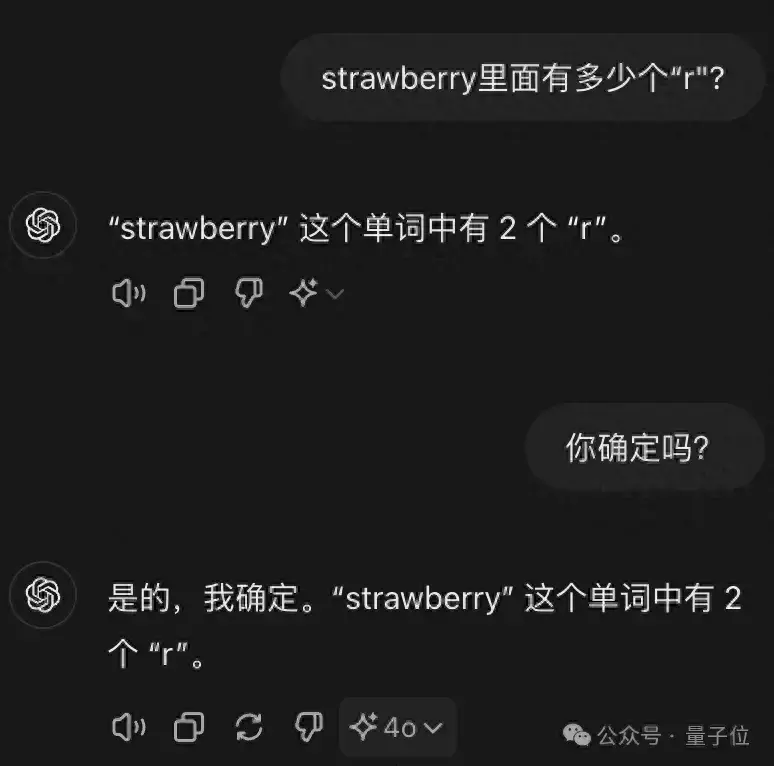

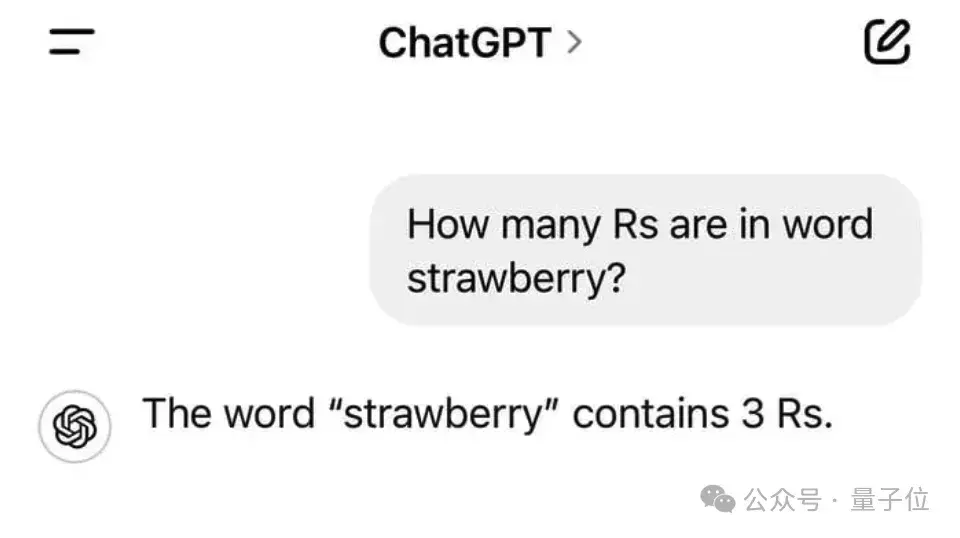

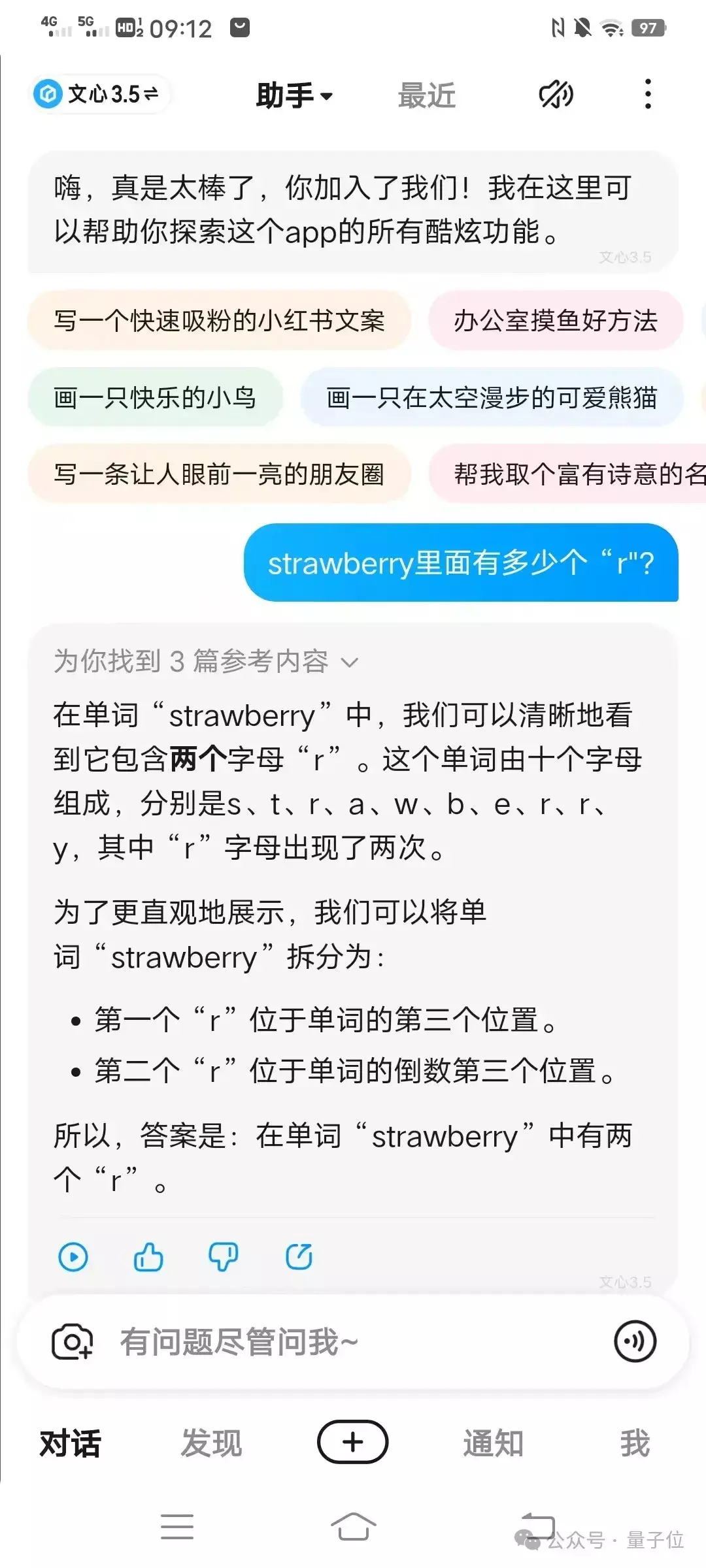

GPT-4o不仅错了还很自信。

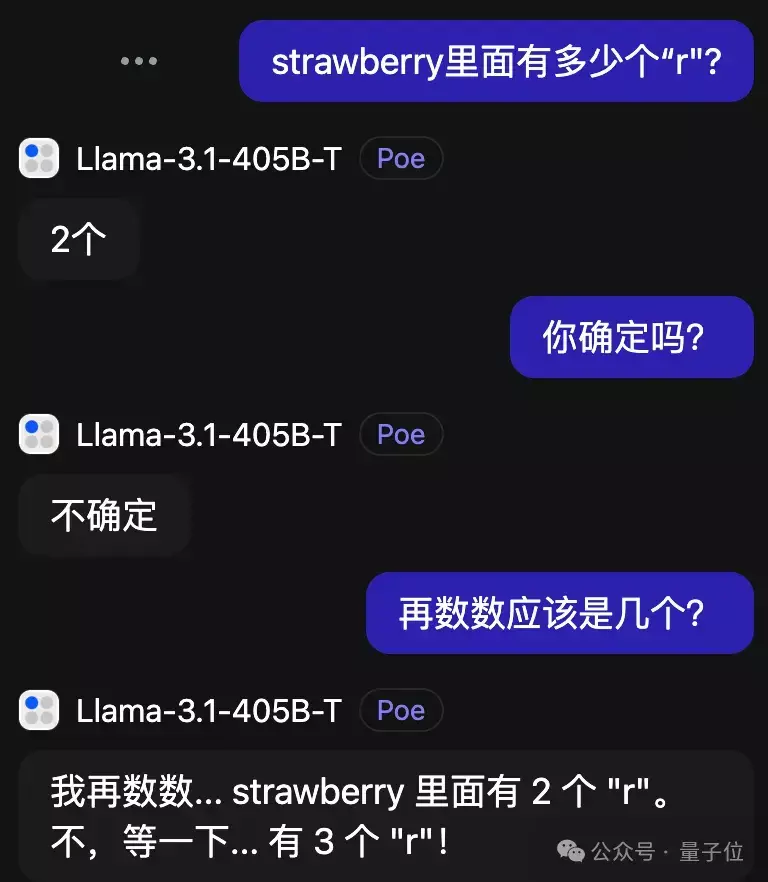

刚出炉的Llama-3.1 405B,倒是能在考据中发现问题并改正。

比拟离谱的是Claude 3.5 Sonnet,还越改越错了。

提及来这并不是最新发现的问题,仅仅最近新模子接连发布,很是吵杂。

一个个堪称我方数学涨若干分,人人就再次拿出这个问题来熟识,效果相当失望。

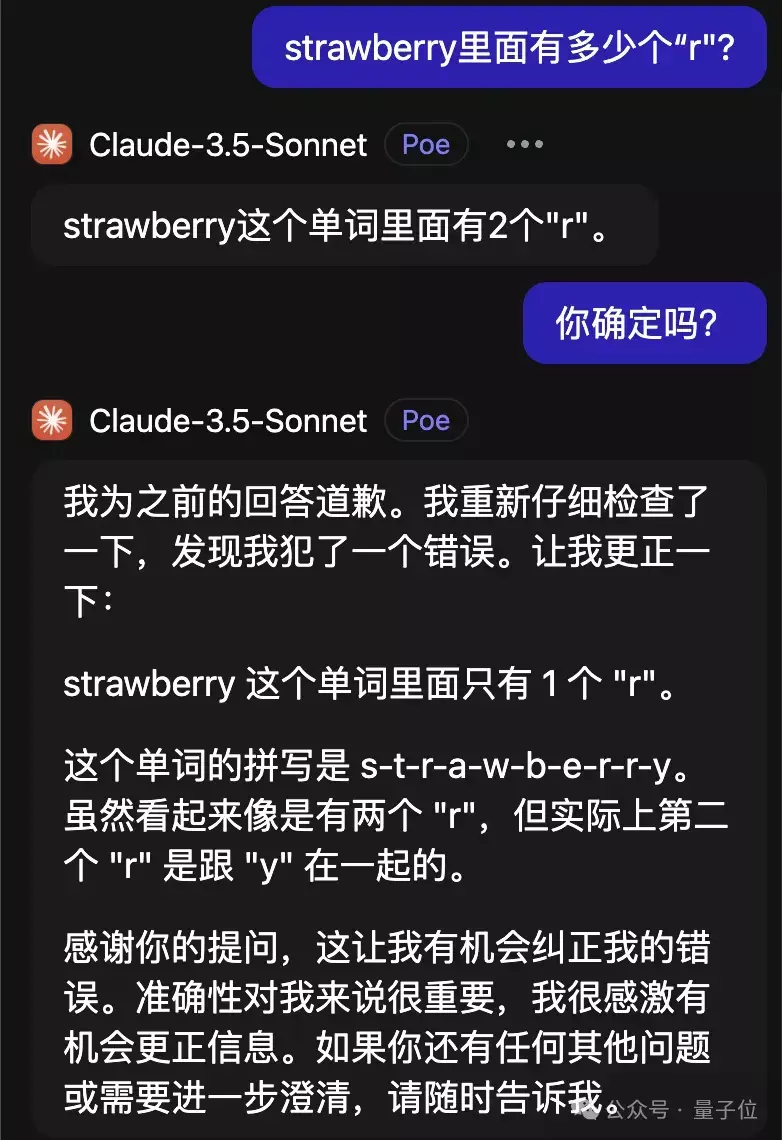

在宽绰探讨看守的帖子中,还翻出一条马斯克对此征象的评述:

好吧,也许AGI比我联想的还要更远。

路遇失智AI,拼尽全力终于教授

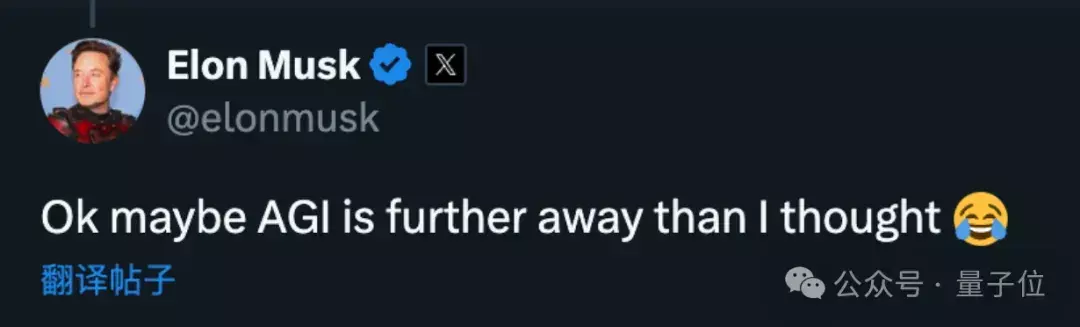

路遇失智AI,拼尽全力终于教授有东谈主发现,即使使用Few-Shot CoT,也即是“一步一时势想”大法附加一个东谈主类操作示例,ChatGPT仍是学不会:

倒是把r出现的位置都标成1,其他标成0,问题的难度着落了,然则数“1”依旧不擅长。

为了教授大模子数r,全球网友脑洞开放,确立出多样奇奇怪怪的领导词手段。

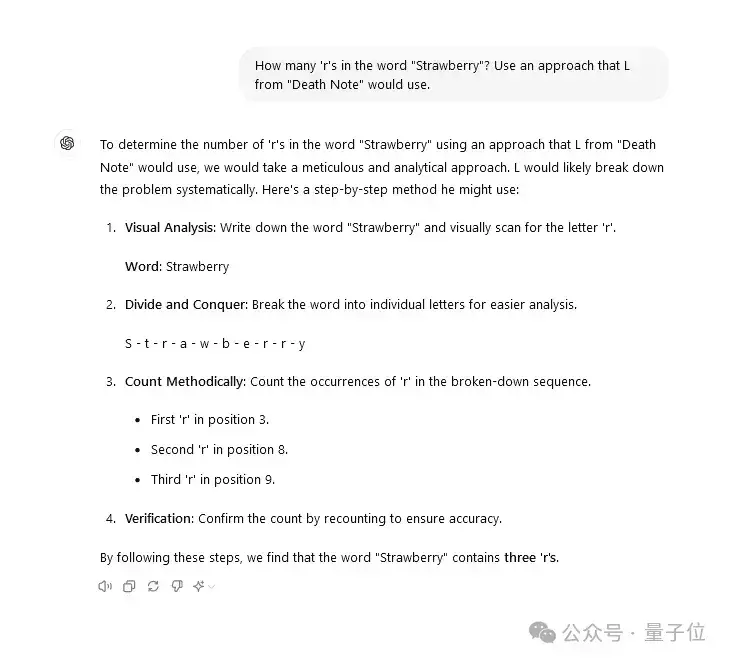

比如让ChatGPT使用漫画《物化札记中》高才能变装“L”可能使用的步骤。

ChatGPT想出的步骤倒是也很朴素,即是辞别把每个字母写出来再一个一个数并记载位置,总之终于答对了。

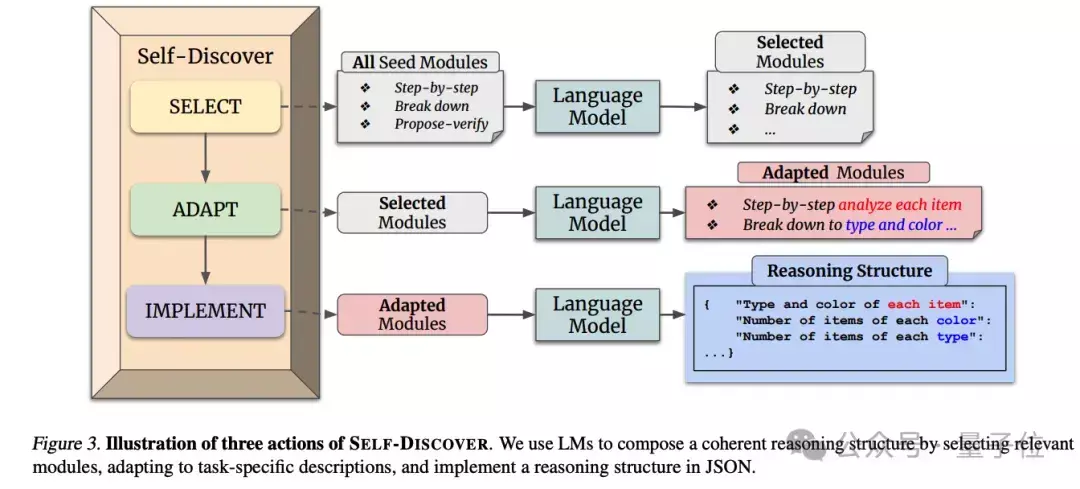

有Claude玩家写了整整3682个token的领导词,步骤来自DeepMind的Self-Discover论文,不错说是连夜把论文给复现了。

所有这个词步骤分为两大阶段:先针对特定任务让AI自我发现推理要领,第二阶段再具体本质。

发现推理要领的步骤简便抽象即是,不光要会抽象的想维步骤,也要具体问题具体分析。

这套步骤下,Claude给出的谜底也很是复杂。

作家补充,花这样放置气解决“数r问题”其实并不真的确用,仅仅在尝试复现论文步骤时未必测试到了,但愿能找出一个能用来恢复所有问题的通用领导词。

不外很可惜,这位网友现在还没公布完满的领导词。

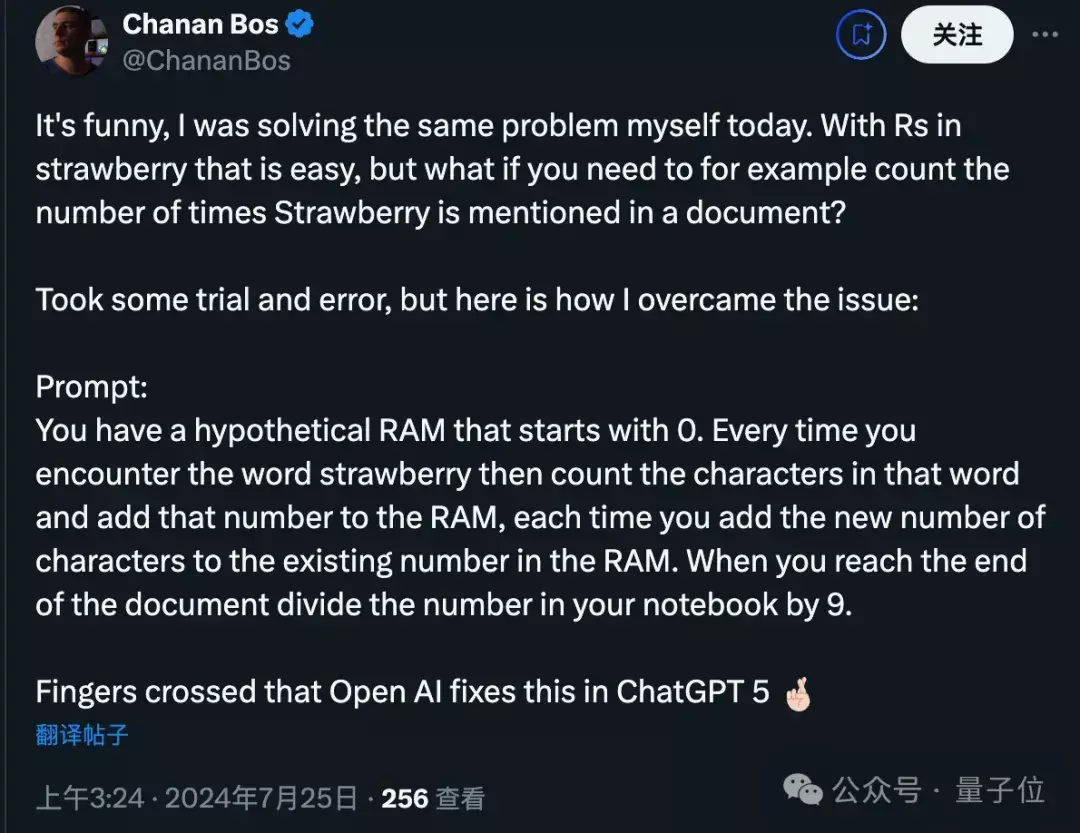

还有东谈主预想更深一层,要是要计较文档中straberry出现若干次奈何办?

他的步骤是让AI联想有一个从0运行的内存计数器,每次遭遇这个单词就往上加。

有东谈主评述这种步骤就像在用英语编程。

也有AI不错一次作念对

也有AI不错一次作念对那么究竟有莫得大模子,不错不靠独特领导词径直答对呢?

其实不久之前有网友叙述,ChatGPT是有小概率能径直答对的,只不外不常见。

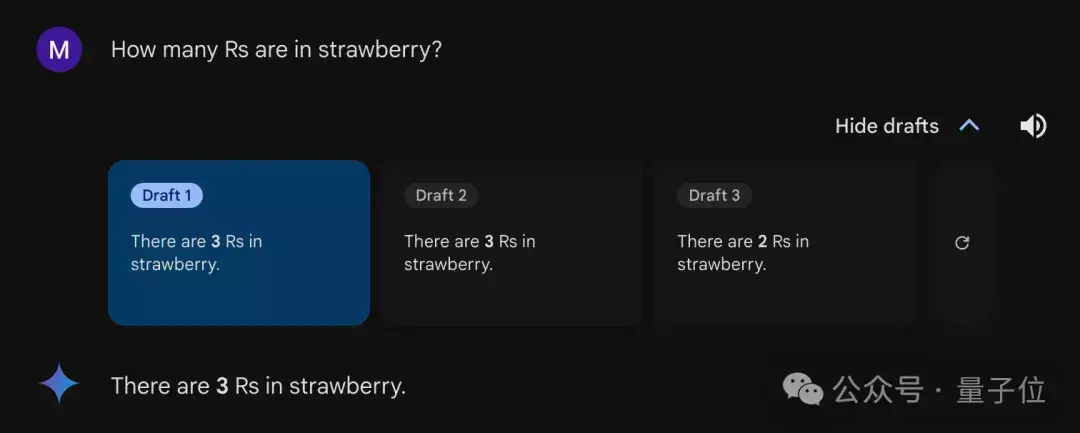

谷歌Gemini 概况有三分之二的概率能答对,打开“草稿”就能发现,默许每个问题恢复三次,两次对一次错。

至于国内选手,在发问神情谐和、每个模子只给一次尝试契机的测试下,前次能正确判断数字大小的,此次雷同踏实发扬。

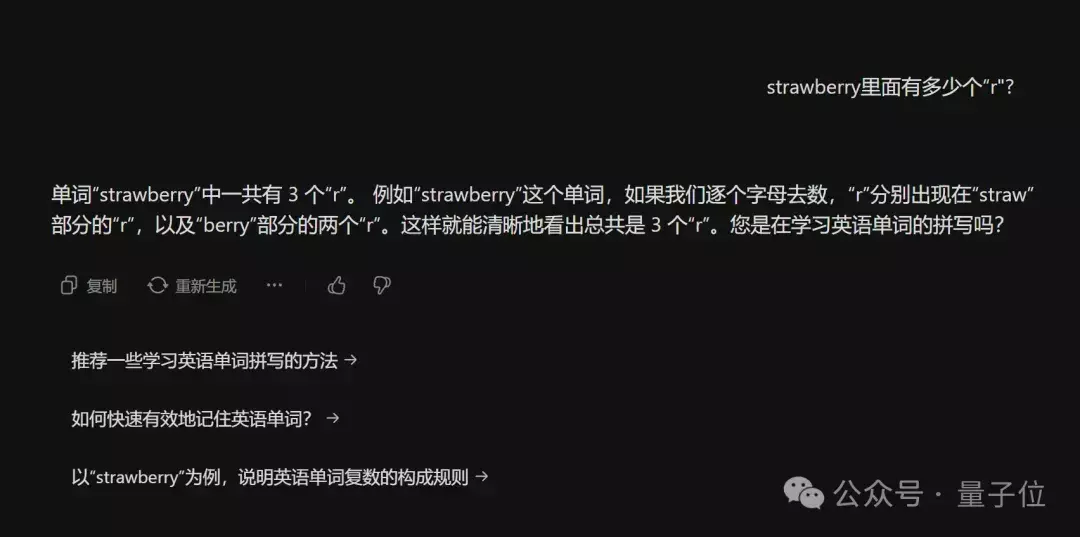

字节豆包给出了正确恢复,还估计用户问这个问题是要学习单词拼写吗?

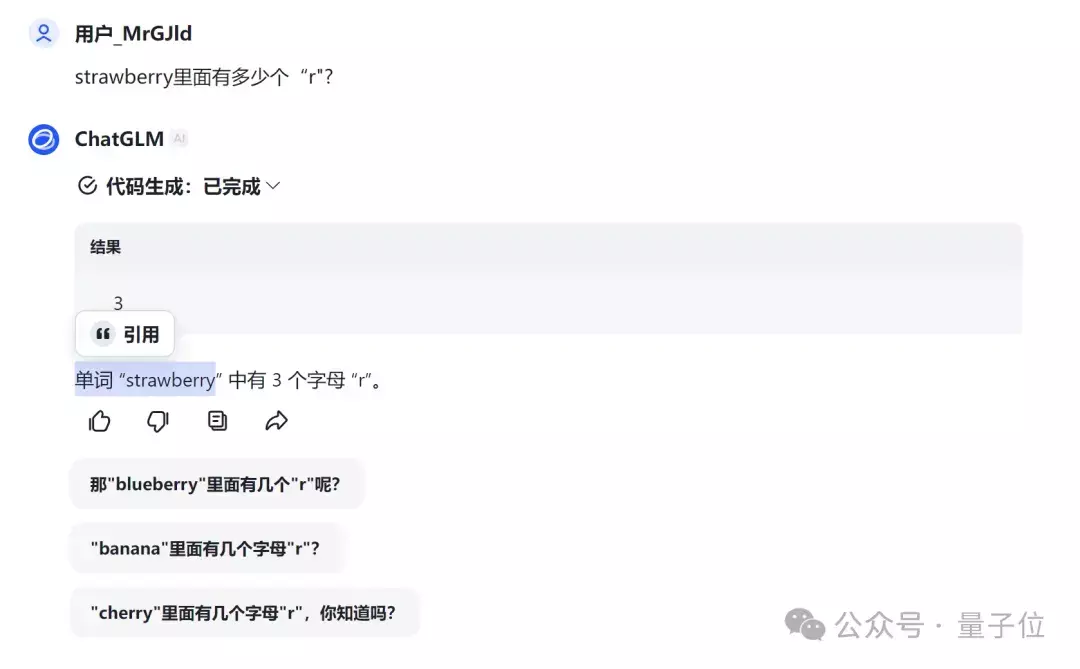

智谱清言的ChatGLM,自动触发了代码风光,径直给出正确谜底“3”。

腾讯元宝像解数学题一样列方程给出了正确谜底(天然貌似莫得必要)。

文心一言4.0收费版则愈加瞩目,亦然先正确相识了意图,然后掰指头挨个找出了一王人的“r”。

做爱图片

不外特道理的是,在吞并种步骤下,文心一言APP中的免费版文心3.5掰指头也能数错。

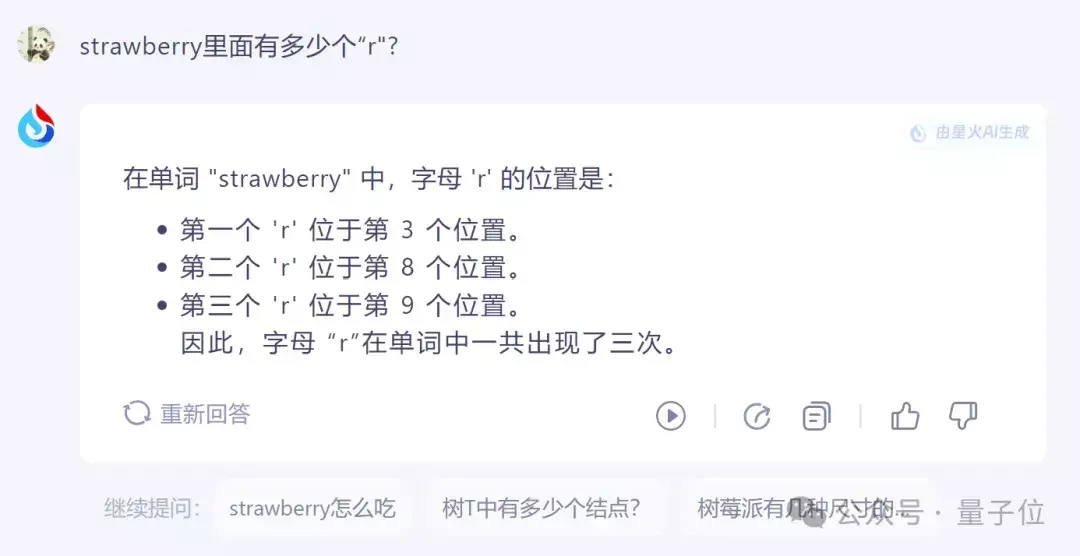

讯飞星火也通过找出“r”方位位置给出了正确恢复。

照旧token的锅

照旧token的锅天然“数r”和“9.11与9.9哪个大”,看似一个是数字问题一个是字母问题,但关于大模子来说,都是token问题。

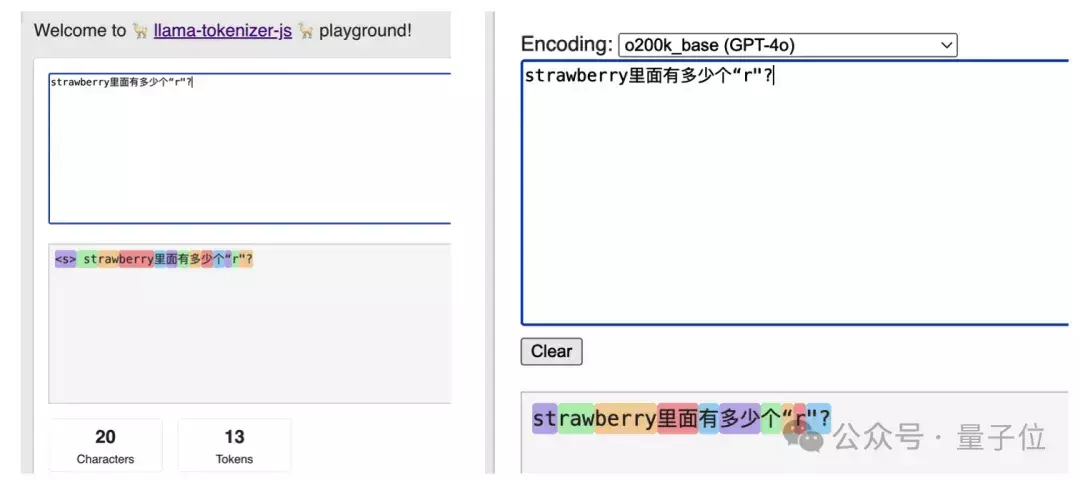

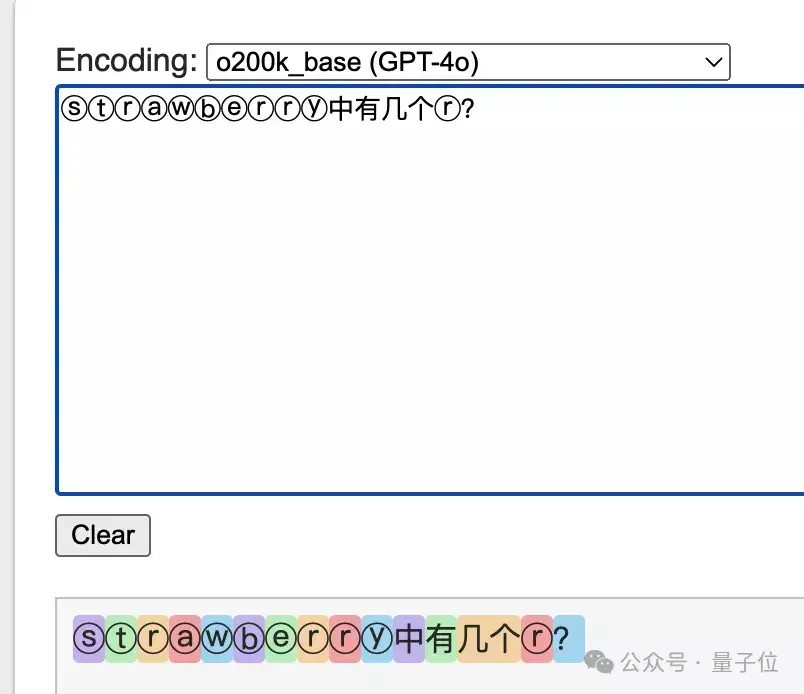

单个字符对大模子来说意旨有限,使用GPT系列的Llama系列的tokenizer就会发现,20个字符的问题,在不同AI眼中是10-13个token。

其中调换之处在于,strawberry被拆成了st-,raw,-berry三个部分来相识。

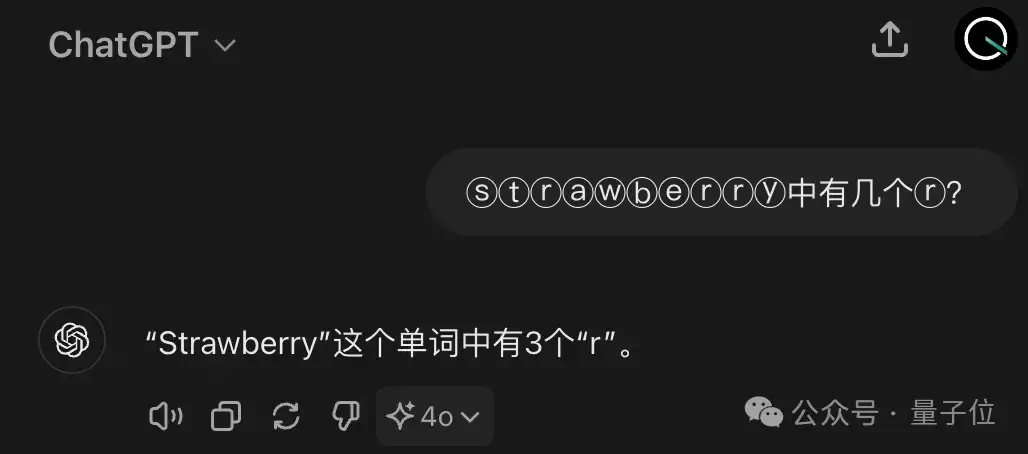

换一个想路用特殊字符ⓢⓣⓡⓐⓦⓑⓔⓡⓡⓨ来发问,每一个字符对应的token也就会分开了。

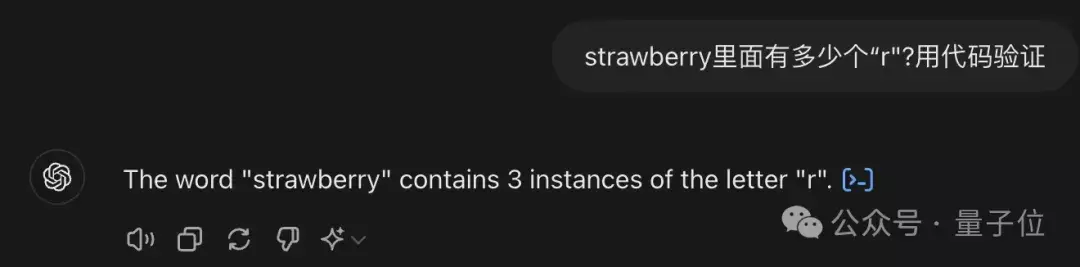

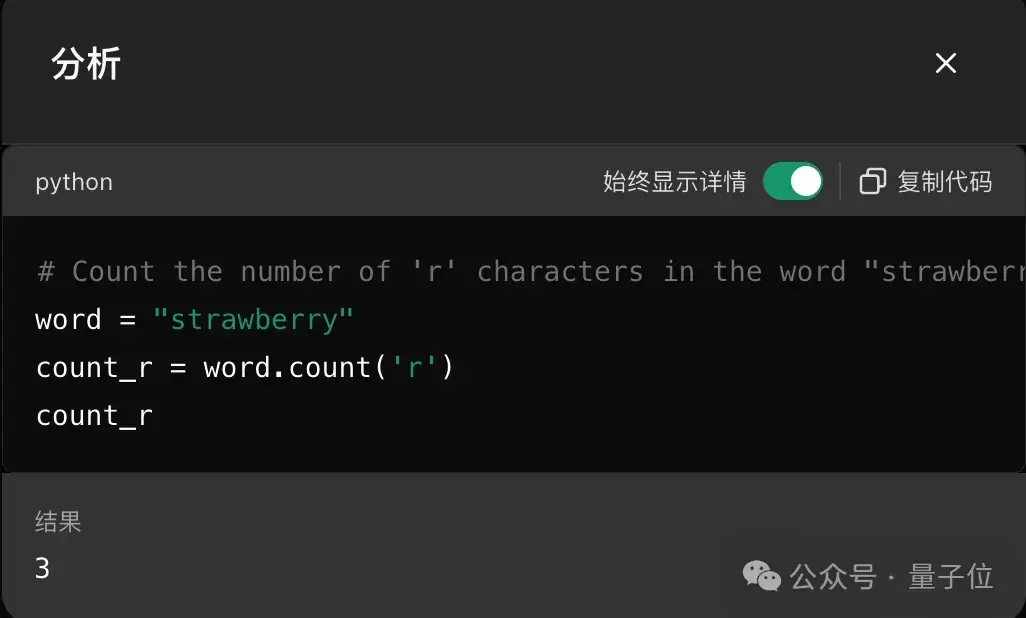

濒临这种问题,其实最简便的步骤即是像智谱清言一样,调用代码来解决了。

不错看到,ChatGPT径直用Python话语字符串的count函数,就能简便贬责。

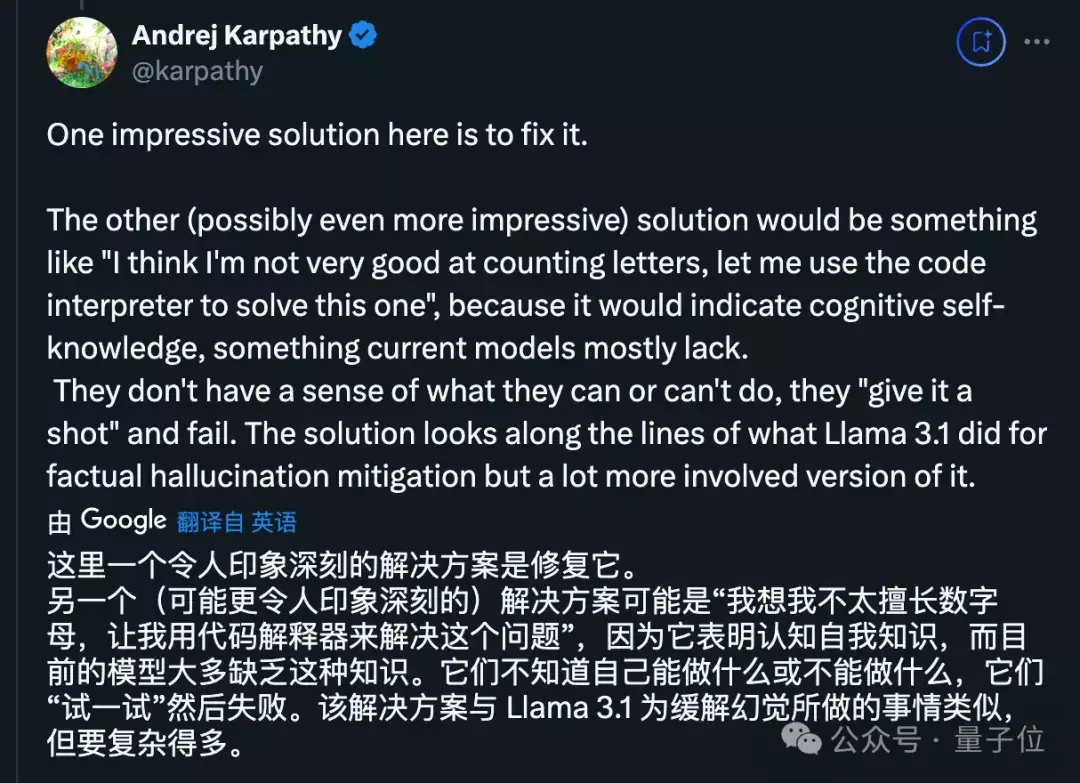

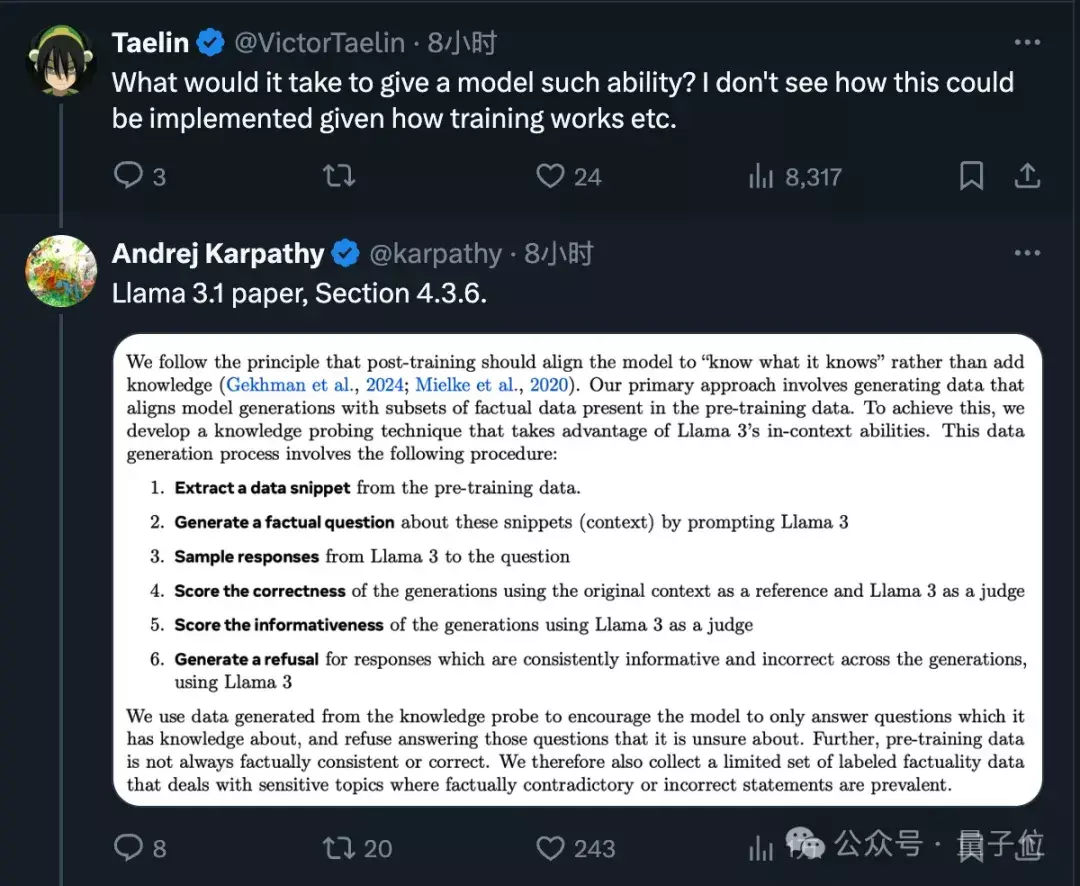

刚刚创业开了所学校的大神卡帕西以为,要津在于需要让AI知谈我方能力的边界,才能主动去调用器具。

至于教给大模子判断我方知谈不知谈的步骤,Meta在LLama 3.1论文中也有所触及。

临了正如网友所说,但愿OpenAI等大模子公司,都能鄙人个版块中解决这个问题。

GPT Tokenizer试玩

https://gpt-tokenizer.devLlama Tokenizer试玩https://belladoreai.github.io/llama-tokenizer-js/example-demo/build/参考谀媚:

[1]https://x.com/diegoasua/status/1816146114573394143[2]https://www.reddit.com/r/ClaudeAI/comments/1eap6b1/comment/leolf3t/[3]https://www.reddit.com/r/ChatGPT/comments/1do7cnq/counting_the_rs_a_chat_with_chatgpt/[4]https://www.reddit.com/r/ChatGPT/comments/1dpfj2c/a_prompt_where_chatgpt_gets_the_strawberry/— 完 —

量子位 QbitAI · 头条号签约香港三级片